Les protocoles de routage classiques échouent dès qu’un segment du réseau devient hostile ou compromis. Certains dispositifs continuent pourtant d’échanger des données, même lorsque la confiance ne peut être établie ni garantie entre les points de passage.

Des vulnérabilités existent à chaque étape, alors que des techniques plus robustes émergent pour pallier l’absence de fiabilité. Les exigences réglementaires évoluent rapidement, imposant des contraintes inédites et bouleversant les schémas d’interconnexion traditionnels.

Pourquoi la sécurité des communications entre réseaux non fiables est devenue incontournable

À l’heure où les systèmes d’information s’ouvrent et se connectent sans limites apparentes, la sécurité réseau n’est plus un simple ajout technique : c’est le socle même de la confiance numérique. Les usages explosent. Un salarié accède aux données depuis une chambre d’hôtel, un partenaire consulte les ressources via une plateforme cloud, des applications communiquent entre infrastructures hybrides. Cette évolution, qui semblait promettre agilité et performance, expose aussi les organisations à des risques qu’elles ne maîtrisent plus de bout en bout.

La circulation des données sensibles sur des réseaux partagés ou loués augmente la vulnérabilité. La moindre faille peut devenir une porte d’entrée pour un vol massif d’informations, un sabotage ou une manipulation de processus critiques. L’attaque ne se limite plus au piratage : une panne, une altération furtive ou une indisponibilité de service peuvent désormais déstabiliser durablement une entreprise, voire ruiner sa réputation. La menace s’adapte, se faufile, change de forme. Face à cette pression, la sécurité n’est plus uniquement une affaire d’ingénieurs, mais engage la gouvernance et la stratégie globale.

Les textes réglementaires, RGPD, HIPAA, normes sectorielles, imposent des obligations strictes en matière de protection des données. Les audits se multiplient : il faut prouver que chaque flux est maîtrisé, chaque accès contrôlé, chaque incident anticipé. Les environnements cloud ne font pas exception : la sécurité des communications entre réseaux externes et internes devient une clause contractuelle incontournable, scrutée par les clients comme par les autorités.

Voici les principaux enjeux qui structurent cette nouvelle donne :

- La sécurité réseau agit comme un rempart : elle protège les systèmes d’information des cyberattaques, limite l’exposition aux pertes financières et assure la continuité d’activité.

- Les obligations réglementaires dictent les politiques de sécurité et engagent la responsabilité de chaque intervenant du numérique.

- L’utilisateur final, souvent maillon faible, devient acteur de la sécurité : sensibilisation, accompagnement et implication sont désormais au cœur des stratégies défensives.

Quels sont les principaux risques et vulnérabilités lors des échanges inter-réseaux ?

Dès qu’un réseau d’entreprise dialogue avec un environnement extérieur, la surface d’attaque s’élargit dangereusement. Les échanges entre réseaux non fiables ouvrent la voie à une multitude de menaces et de vulnérabilités, parfois insoupçonnées. Un seul maillon faible suffit : une mauvaise configuration, un accès sans fil non protégé, une faille logicielle, et tout l’écosystème peut être compromis.

Dans la pratique, les attaques les plus redoutées prennent la forme de logiciels malveillants, d’écoutes furtives sur les flux (attaques « man-in-the-middle »), ou de blocages coordonnés (déni de service). Les points d’accès Wi-Fi mal sécurisés deviennent des cibles de choix pour détourner du trafic ou injecter du code malicieux. Et la complexité croissante des architectures rend chaque erreur de configuration potentiellement explosive : il suffit d’une règle de pare-feu mal appliquée pour qu’un intrus contourne toutes les protections.

La bonne nouvelle : la segmentation réseau offre un moyen efficace de limiter les dégâts. En isolant les environnements critiques, en compartimentant droits et accès, on empêche une attaque de se propager comme une traînée de poudre. Dans les industries, cette isolation est vitale : les réseaux de commande (SCI, SCADA) doivent rester hermétiques aux flux informatiques classiques. Les systèmes de détection d’intrusion (IDS) et la surveillance continue constituent une autre ligne de défense : ils signalent les comportements anormaux, mais leur efficacité dépend de leur capacité à analyser la diversité des flux et à repérer les signaux faibles.

Pour mieux cerner les principales failles à surveiller, voici une synthèse des vecteurs les plus courants :

- Diffusion rapide de logiciels malveillants via des points d’échanges non filtrés

- Failles persistantes sur les points d’accès sans fil

- Manque ou défaut de segmentation du réseau interne

- Exploitation d’erreurs dans la configuration des équipements

Face à ces risques, il n’existe pas de solution miracle : seule une approche méthodique, conjuguant technologies et bonnes pratiques, permet de contenir les menaces et de préserver la fiabilité de l’infrastructure.

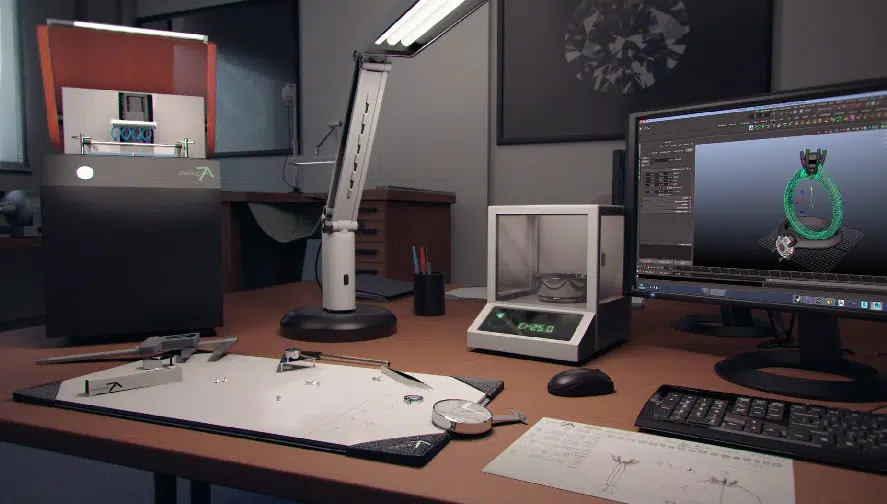

Panorama des technologies pour sécuriser les communications sur des réseaux non fiables

Pour verrouiller les échanges entre réseaux non fiables, les organisations misent sur un arsenal technologique en perpétuelle évolution. En première ligne : le VPN, qui chiffre les flux et protège les données d’éventuels regards indiscrets durant leur transit. Les protocoles SSL/TLS et IPsec renforcent cette protection, s’appliquant aussi bien aux sessions applicatives qu’aux paquets IP circulant entre sites distants ou vers le cloud.

Les pare-feu de nouvelle génération filtrent de manière intelligente chaque paquet, s’appuyant sur des règles adaptatives pour bloquer les tentatives d’intrusion. La segmentation réseau, qu’elle soit réalisée via des VLAN, de la microsegmentation ou des solutions SDN, cloisonne les zones sensibles et réduit la portée d’une attaque. Pour contrôler l’accès, l’authentification forte (2FA, MFA) s’impose : chaque utilisateur doit prouver son identité à chaque connexion. Des outils comme Kerberos ou l’Active Directory centralisent la gestion des identités et orchestrent les droits d’accès.

Le modèle Zero Trust redistribue les cartes : il ne présume jamais de la fiabilité d’un utilisateur ou d’un appareil, même à l’intérieur du périmètre. Chaque requête, chaque connexion, est vérifiée en temps réel. Les systèmes de détection et de prévention d’intrusions (IDS/IPS) examinent les flux à la recherche d’anomalies, appuyés par des filtres de contenu et des solutions anti-malware ou anti-ransomware qui veillent à la propreté des échanges.

Pour mieux visualiser les technologies incontournables, voici les principales briques de sécurité adoptées aujourd’hui :

- VPN et protocoles de chiffrement : SSL/TLS, IPsec, SSH, WPA2/WPA3

- Pare-feu, segmentation et microsegmentation

- Authentification forte et gestion des droits par rôles (RBAC)

- Détection et prévention d’intrusions (IDS/IPS)

Ce socle technique, renforcé par une supervision continue et une gestion fine des accès, forme une barrière robuste contre des menaces qui n’attendent qu’une faille pour s’engouffrer.

Bonnes pratiques et solutions concrètes pour renforcer la sécurité de vos échanges

Protéger les échanges entre réseaux non fiables, ce n’est pas uniquement une affaire d’outils : sans discipline ni méthode, la technologie seule ne suffit pas. Les spécialistes s’accordent sur une priorité : la segmentation réseau doit être pensée dès l’architecture. Cloisonner, isoler, limiter les droits d’accès, autant de gestes simples qui rendent la vie compliquée à un attaquant. La microsegmentation couplée à des VLAN permet d’adapter la protection à la réalité des métiers et aux exigences des régulateurs.

La surveillance active s’impose, elle aussi, comme un réflexe : il s’agit de déployer des outils d’audit et de monitoring capables de repérer immédiatement toute anomalie ou comportement suspect. L’automatisation, via des cadres comme l’ITSG-33, élève le niveau de sécurité en détectant les incidents avant même qu’ils ne prennent de l’ampleur. Et lorsque l’incident survient, seule une gestion structurée et des procédures de réponse parfaitement rodées permettent de limiter l’impact et de restaurer l’activité au plus vite.

Le Centre pour la cybersécurité pose les jalons de cette discipline exigeante : il préconise dix mesures incontournables, depuis la séparation stricte des informations jusqu’à l’adoption du modèle Zero Trust. Chaque accès doit être vérifié, sans exception, à chaque instant. La conformité aux exigences réglementaires (RGPD, HIPAA) s’inscrit alors naturellement dans cette dynamique, au service de la confidentialité, de l’intégrité et de la disponibilité.

Pour concrétiser cette approche, voici les pratiques qui font la différence au quotidien :

- Segmentez le réseau pour contenir les menaces

- Déployez une supervision continue avec alertes sur mesure

- Formalisez des plans d’intervention face aux incidents

- Appliquez le principe de confiance zéro sur tous les accès

En matière de sécurité réseau, chaque détail compte. C’est dans la rigueur quotidienne et l’anticipation que se forgent les défenses les plus solides. D’ici peu, ce sont ceux qui auront su construire ces remparts invisibles qui feront la différence, quand la tempête numérique viendra frapper à la porte.