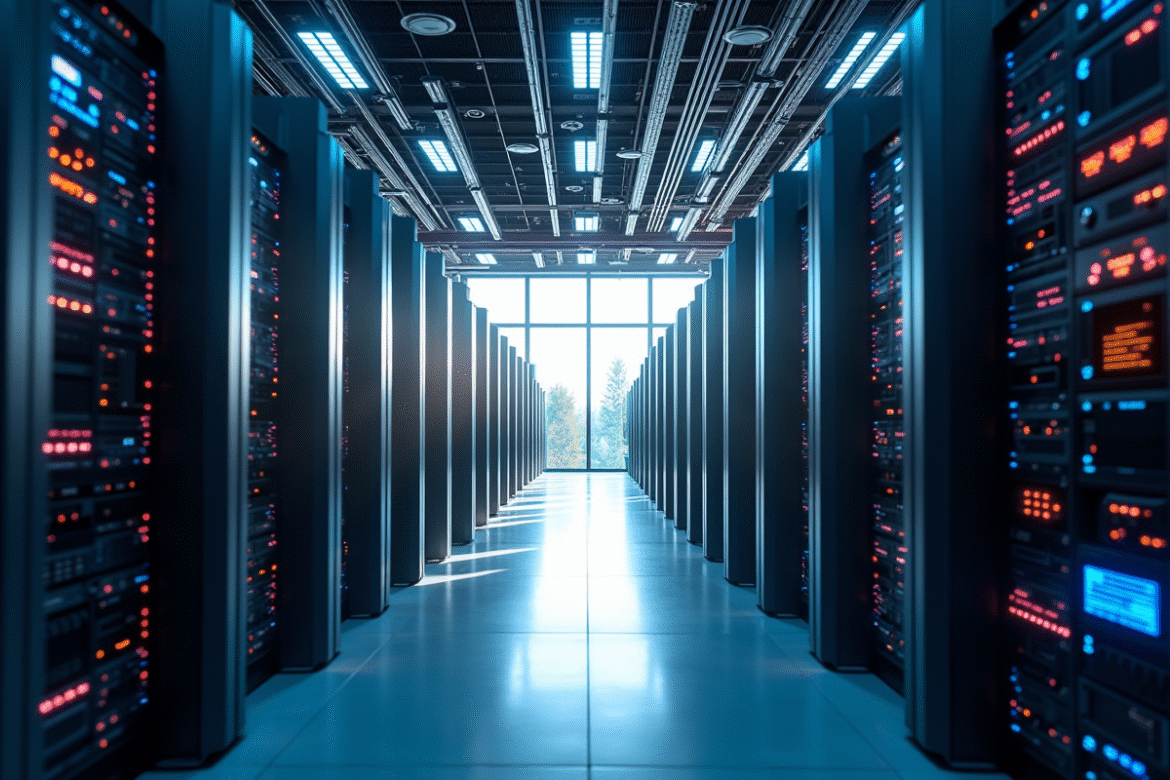

Personne ne voit les serveurs surchauffés. Pourtant, derrière chaque question posée à une intelligence artificielle, ce sont des myriades de machines qui s’activent, avalant en silence des kilowattheures à la chaîne. Sous l’éclat des prouesses algorithmiques, la réalité est têtue : les centres de données, usines de l’ère numérique, font tourner la planète à grands renforts d’électricité.

Faut-il sacrifier la course à la performance sur l’autel de la sobriété énergétique ? Tandis que la consommation grimpe, le dilemme secoue ingénieurs et décideurs. La question ne se limite plus au choix d’un processeur ou d’un algorithme : il s’agit désormais de maîtriser la puissance, sans exploser la facture carbone. Peut-on vraiment allier force de calcul et responsabilité écologique ?

Pourquoi l’essor de l’IA bouleverse la consommation électrique des centres de données

La consommation électrique des data centers s’envole, portée par l’essor fulgurant de l’intelligence artificielle. L’Agence internationale de l’énergie prédit déjà un doublement de la part de l’électricité mondiale engloutie par ces infrastructures d’ici 2026, entraînée par la soif de puissance de l’IA générative. Nul territoire n’est épargné : de l’Europe aux États-Unis, en passant par l’Asie, fleurissent des « super-centres » bardés de semi-conducteurs Nvidia, orchestrés par Google, Microsoft ou Amazon Web Services.

L’impact environnemental ne se limite pas à la seule course à la puissance. Le refroidissement, indispensable pour échapper à la surchauffe, peut représenter plus de 40 % de la dépense énergétique. L’Ademe tire la sonnette d’alarme : l’empreinte carbone de ces infrastructures ne cesse de s’alourdir, surtout dans un contexte où la transition énergétique patine.

- Un centre de données IA peut consommer jusqu’à dix fois plus d’électricité qu’un data center classique dédié au stockage.

- L’entraînement d’un grand modèle génératif engendre autant d’émissions carbone que plusieurs centaines de vols transatlantiques.

La consommation énergétique des centres de données s’impose désormais comme un terrain de rivalité économique et politique. Face à la pression, les mastodontes du cloud investissent dans des architectures toujours plus efficaces, tout en traquant la moindre réduction d’empreinte carbone. La question n’est plus de savoir si l’IA rebat les cartes de l’énergie : il s’agit de mesurer jusqu’où ira cette transformation.

Combien consomme réellement un centre de données dédié à l’intelligence artificielle ?

Impossible de balayer la question sous le tapis : la consommation énergétique d’un centre IA dépasse largement celle de son cousin dédié au stockage simple. D’après l’Ademe, une installation de taille moyenne, entièrement consacrée à l’intelligence artificielle, peut afficher une puissance installée supérieure à 20 mégawatts – autant qu’une petite ville.

La cause ? Pour entraîner les modèles IA, il faut des serveurs spécialisés – GPU Nvidia, accélérateurs maison – qui réclament leur dose d’électricité, et, pour ne rien arranger, génèrent une chaleur considérable. Résultat : un rack IA peut engloutir 50 kilowatts, là où un rack traditionnel se contente de 5 à 10. La chaleur dégagée impose le recours à des systèmes de refroidissement liquide, à la fois performants et gourmands.

- Un centre IA de 10 000 m² peut absorber plus de 100 gigawattheures par an.

- La facture énergétique annuelle se chiffre en millions d’euros, selon les équipements et la localisation.

Chez Google et Microsoft, les nouvelles générations de centres IA s’affichent avec des efficacités énergétiques (PUE) frôlant 1,1. Mais la moyenne mondiale reste autour de 1,5, selon l’Ademe. Tout se joue sur le choix de l’électricité, l’innovation dans les systèmes de refroidissement et l’orchestration des charges de calcul : ces leviers font ou défont l’empreinte énergétique d’un centre de données.

Les leviers techniques et organisationnels pour réduire la facture énergétique

Pour contenir la consommation énergétique des centres IA, il faut jouer sur tous les tableaux. L’optimisation commence à la racine : architecture modulaire, matériaux à faible empreinte, et implantation calculée près de sources d’énergies renouvelables.

La gestion de la chaleur fatale devient alors un axe stratégique. Plutôt que de la rejeter, certains centres la réutilisent pour chauffer des logements voisins ou alimenter des réseaux urbains. Les systèmes de refroidissement liquide, de plus en plus répandus, abaissent le PUE sous 1,2 dans certains sites français : un saut d’efficacité qui change la donne.

- Des algorithmes de gestion en temps réel répartissent intelligemment la charge, évitant les pics inutiles.

- L’installation de panneaux photovoltaïques ou la signature de contrats d’électricité verte ancrent ces centres dans la transition énergétique.

La certification ISO 50001 marque la volonté d’avancer : elle impose une gestion rigoureuse des consommations et un pilotage continu. Selon l’Ademe, ces démarches permettent d’obtenir jusqu’à 25 % d’économies d’énergie sur un centre IA bien piloté. Dernière pièce du puzzle : la formation des équipes, car un geste éco-responsable n’est jamais anodin à l’échelle de milliers de serveurs.

Vers des centres de données IA plus sobres : innovations et pistes d’avenir

La sobriété énergétique n’est plus une option, c’est la prochaine frontière pour les centres IA. Google, AWS, Nvidia : tous cherchent la formule magique pour contenir la consommation énergétique sans brider la puissance de calcul.

Les nouveaux concepts bousculent les habitudes. Architecture « serverless », virtualisation évoluée : on mutualise, on adapte, on évite le gaspillage. Le recours aux sources d’énergie renouvelables – solaire, hydraulique, éolien – s’accélère, surtout en Europe, où la moitié des nouveaux centres se branchent au vert.

- Le refroidissement par immersion plonge serveurs et composants dans des fluides sur-mesure, réduisant la chaleur à la source.

- L’intelligence artificielle elle-même pilote la gestion énergétique, anticipant les pics et modulant le refroidissement à la volée.

L’Ademe table sur 30 % de réduction de la consommation électrique d’ici dix ans, grâce à ces innovations. Les normes évoluent, la transparence devient la règle, poussant tout le secteur à repenser ses pratiques.

Des modèles hybrides émergent : cloud public, infrastructures locales, combinaisons sur-mesure. La filière trace ainsi un chemin réaliste vers une transition énergétique responsable, où l’IA promet de rester puissante sans faire fondre la planète. Le centre de données de demain ne sera pas seulement un monstre de calcul, mais un champion de la sobriété. Qui aurait parié là-dessus il y a dix ans ?